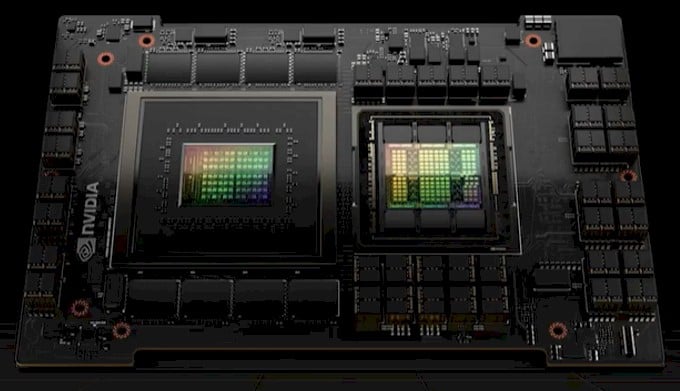

Анализ Тъй като законът на Мур се забави до пълзене, чиповете, особено тези, използвани в AI и високопроизводителните изчисления (HPC), непрекъснато стават все по-горещи. През 2023 г. видяхме ускорителите да навлизат в киловатовия диапазон с пристигането на суперчиповете GH200 на Nvidia.

Знаем, че тези чипове ще бъдат горещи от известно време – Nvidia дразни CPU-GPU franken-chip през по-голямата част от две години. Това, което не знаехме доскоро, е как производителите на оригинално оборудване и създателите на системи биха реагирали на такава енергоемка част. Дали повечето системи ще бъдат с течно охлаждане? Или повечето биха се придържали към въздушно охлаждане? Колко от тези ускорители ще се опитат да натъпчат в една кутия и колко голяма ще бъде кутията?

Сега, когато първите системи, базирани на GH200, си проправят път към пазара, стана ясно, че форм-факторът до голяма степен се диктува от плътността на мощността, отколкото от всичко друго. По същество се свежда до това колко повърхност трябва да разсеете топлината.

Разровете се в наличните днес системи от Supermicro, Gigabyte, QCT, Pegatron, HPE и други и бързо ще забележите тенденция. До около 500 W на стелаж (RU) – 1 kW в случая на MGX ARS-111GL-NHR на Supermicro – тези системи са предимно с въздушно охлаждане. Докато е горещ, той все още е управляем термичен товар за разсейване, работещ до около 21-24 kW на шкаф. Това е в рамките на капацитета за доставка на енергия и управление на топлината на съвременните центрове за данни, особено тези, които използват топлообменници на задната врата.

Това обаче се променя, когато създателите на системи започнат да натъпкват повече от един киловат ускорители във всяко шаси. В този момент повечето от OEM системите, които разгледахме, преминаха към директно течно охлаждане. H263-V11 на Gigabyte, например, предлага до четири GH200 възела в едно 2U шаси.

Това са два киловата на стелаж. Така че докато система като DGX H100 с въздушно охлаждане на Nvidia със своите осем 700 W H100s и двойни процесори Sapphire Rapids има по-висок TDP при 10,2 kW, тя всъщност е с по-малка мощност при 1,2 kW/RU.

Има няколко предимства на течното охлаждане извън по-ефективното пренасяне на топлина от тези плътно опаковани ускорители. Колкото по-висока е мощността на системата, толкова повече статично налягане и въздушен поток са ви необходими, за да отстраните топлината от системата. Това означава да използвате по-горещи, по-бързи вентилатори, които използват повече мощност – потенциално до 20 процента от мощността на системата в някои случаи.

Отвъд около 500 W на стелаж, повечето от OEM и ODM производителите изглежда избират шасита с течно охлаждане, тъй като са необходими по-малко, по-бавни вентилатори за охлаждане на компоненти с по-ниска мощност като NIC, съхранение и други периферни устройства.

Трябва само да погледнете блейдовете Cray EX254n на HPE, за да видите колко много има шасито с течно охлаждане. Тази платформа може да поддържа до четири GH200. Това е потенциално 4 kW в 1U изчислителен блейд и това дори не включва мрежовите карти, използвани за захранване на чиповете с данни.

Разбира се, хората от подразделението Cray на HPE знаят нещо или две за охлаждането на свръхплътни изчислителни компоненти. Това обаче илюстрира количеството мисъл, която създателите на системи са вложили в своите сървъри, не само на системно ниво, но и на ниво шкаф.

Rack ниво излита

Както споменахме преди със системите Nvidia DGX H100, охлаждането на мултикиловатов сървър самостоятелно е нещо, с което OEM производителите са добре запознати. Но веднага щом се опитате да напълните шкаф с тези системи, нещата стават малко по-сложни с фактори като мощност на шкафа и охлаждане на съоръжението, които влизат в действие.

Ние се потопихме в предизвикателствата, които операторите на центрове за данни като Digital Reality трябваше да преодолеят, за да поддържат гъсто внедряване на тези видове системи в нашата родствена публикация The Next Platform .

В много случаи доставчикът на колокация трябваше да преработи своята инфраструктура за захранване и охлаждане, за да поддържа повече от 40 киловата мощност и топлина, необходими за опаковане на четири от тези системи DGX H100 в един шкаф.

Но ако вашият център за данни или доставчик на колокация не може да достави такъв тип захранващ шкаф или да се бори с топлината, няма много смисъл да се опитвате да направите тези системи толкова плътни, когато по-голямата част от шкафа ще стои празна.

С пускането на пазара на GH200 видяхме, че Nvidia се фокусира по-малко върху отделните системи и повече върху внедряването в стелаж. За пръв път видяхме това по време на Computex тази пролет с неговия клъстер DGX GH200.

Вместо куп гъсти възли, пълни с GPU, системата всъщност се състои от 256 2U възли, всеки с един GH200 ускорител вътре. Комбинирана, системата е в състояние да изпомпва exaFLOPS от FP8 производителност, но трябва да бъде много по-лесна за внедряване на ниво съоръжения. Вместо 1,2 kW/RU сега гледате по-близо до 500 W/RU, което е точно там, където повечето OEM производители кацат със собствените си системи с въздушно охлаждане.

Съвсем наскоро видяхме Nvidia да кондензира по-малка версия на това до един шкаф с GH200-NVL32, обявен в сътрудничество с AWS на Re:Invent тази есен .

Тази система пакетира 16 1U шасита, всяко оборудвано с два GH200 възела, в един шкаф и ги свързва заедно с помощта на девет NVLink превключватели. Излишно е да казвам, че при 2 kW/RU изчисления това са плътни малки системи и поради това са проектирани да бъдат течно охлаждани от самото начало.

По-горещи чипове на път

Въпреки че се съсредоточихме върху Grace Hopper Superchips на Nvidia, производителят на чипове едва ли е единственият, който тласка TDP до нови граници в преследване на производителност и ефективност.

По-рано този месец AMD разля чашата с най-новите си AI и HPC GPU и APU, при които ускорителите Instinct на компанията скачат от 560 W последно поколение до 760 W. Това все още не е киловатът мощност, изискван от GH200, но това е значително увеличение.

По-важното е, че техническият директор на AMD Марк Пейпърмастър каза пред The Register , че все още има достатъчно място за увеличаване на TDP през следващите няколко години.

Дали това в крайна сметка ще накара производителите на чипове да наложат течно охлаждане за своите водещи части остава без отговор. Според Papermaster, AMD ще поддържа въздушно и течно охлаждане на своите платформи. Но както видяхме с новия MI300A APU на AMD, продължаването на избора на въздушно охлаждане почти сигурно ще означава отстъпки в производителността.

MI300A е номинално оценен за 550 W. Това е много по-малко от 850 W, които бяхме накарани да вярваме, че ще изсмуче при натоварване, но при адекватно охлаждане може да работи дори по-горещо. В HPC-настроена система, като тези, разработени от HPE, Eviden (Atos) или Lenovo, чипът може да бъде конфигуриран да работи на 760 W.

Междувременно Intel проучва нови методи за охлаждане на 2 kW чипове, използвайки двуфазни охлаждащи течности и вдъхновени от коралите радиатори, предназначени да насърчават образуването на мехурчета.

Производителят на чипове също така обяви обширни партньорства с доставчици на инфраструктура и химикали за разширяване на използването на технологии за течно охлаждане. Последното сътрудничество на компанията има за цел да разработи охлаждащо решение за предстоящия Guadi3 AI ускорител на Intel, използвайки технологията за двуфазно охлаждане на Vertiv. ®