Коментар Новата година вече се очертава да бъде една от най-значимите по отношение на силикона за центрове за данни, който сме виждали от известно време. Всяка голяма компания за чипове е планирана да обнови своите CPU и/или GPU продуктови линии през следващите дванадесет месеца.

Nvidia има множество нови ускорители, GPU архитектури и мрежов комплект, планиран за 2024 г. Intel ще пусне може би най-завладяващите си Xeon от години заедно с новите чипове за изкуствен интелект Habana Gaudi. Междувременно AMD, която се движи високо с пускането на своята серия MI300, е планирана да пусне своите процесори Epyc от 5-то поколение на пазара.

Без конкретен ред, нека разгледаме някои от пусканията на по-големи чипове за центрове за данни на нашия радар през 2024 г. О, и ако смятате, че сме пропуснали някой, уведомете ни в коментарите или имейла .

Пристигат AI чиповете HBM3e-toting H200 на Nvidia

Сред първите нови чипове, които ще излязат на пазара през 2024 г., ще бъдат ускорителите H200 на Nvidia. Графичният процесор е по същество опресняване на почтения H100.

Може да очаквате най-новият чип да предложи подобрение на производителността спрямо по-стария си брат, но това няма да стане в конвенционалния смисъл. Разровете спецификационния лист и ще видите, че производителността с плаваща запетая е идентична с тази на H100. Вместо това повишаването на производителността на частта – Nvidia твърди, че е двойно по-висока от производителността за LLM, включително Llama 70B – се свежда до стековете памет HBM3e на чипа.

HGX H200 на Nvidia е настроен да опакова до осем H200 SXM ускорителя на една платка

Обещано ни е, че H200 ще се предлага с до 141 GB HBM3e памет, което е добре за невероятните 4,8 TB/s честотна лента. С нарастването на популярността на LLM – като Llama 2 на Meta, Falcon 40B, Stable Diffusion и други – капацитетът на паметта и честотната лента оказват огромно влияние върху производителността на изводите – а именно колко голям модел можете да поставите в един ускорител или сървър, и колко заявки можете да обработвате едновременно.

Както наскоро проучихме в нашия анализ на провала на сравнителния анализ на AMD и Nvidia, FLOPS не са толкова важни, колкото капацитетът на паметта и честотната лента, когато става въпрос за тези видове натоварвания на AI.

Заместникът на Hopper пристига с архитектура „Blackwell“.

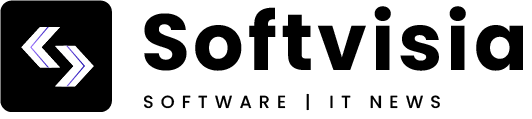

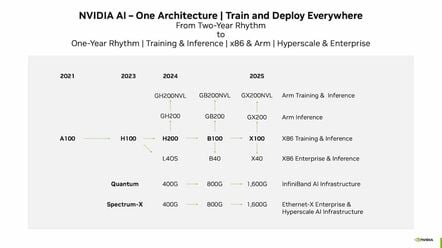

Според презентация на инвеститор през 2023 г., H200 няма да е единственият GPU, който виждаме от Nvidia през 2024 г. За да затвърди лидерството си, Nvidia преминава към годишен ритъм на пускане на нови чипове и първата нова част, която виждаме от Team Green ще бъде B100.

Nvidia планира да премине към едногодишен каданс на пускане, съдейки по този слайд, показан на инвеститорите

Както разбираме, „B“ тук е съкратено от името на микроархитектурата, Blackwell – вероятно намигване към американския статистик David Blackwell. Все още не знаем много за частта, освен че идва през 2024 г. Нашите колеги от The Next Platform имат няколко мисли за B100 тук .

В сегашния си вид, наскоро пуснатите MI300X GPU на AMD не само избутват повече FLOPS от H200, те имат повече и по-бърза памет за зареждане. Не можем да си представим, че Nvidia е доволна от това, особено като се има предвид колко отбранителен е американският гигант напоследък. Поради това напълно очакваме B100 да достави повече FLOPS и повече стекове HBM3e, които ще издигнат капацитета на паметта и честотната лента на ускорителя до нови висоти.

Наред със самия GPU, пътната карта на Nvidia включва повече CPU-GPU суперчипове, наречени GB200 и GB200NVL. Дали тези процесори ще продължат да използват процесорни ядра, базирани на Arm Neoverse V2, намиращи се в текущата реколта от суперчипове Grace и Grace-Hopper, или ще разполагат с ядра от следващо поколение, остава да видим.

След това има B40. Исторически тези видове карти са били насочени към по-малки корпоративни работни натоварвания, които могат да работят в рамките на един GPU. Частта ще замени L40 и L40S и ще консолидира гамата корпоративни GPU на Nvidia под една всеобхватна архитектура.

Вероятно най-интересният компонент от ускорената пътна карта на Nvidia е свързан с работата в мрежа. Nvidia се стреми да премине към 800Gb/s свързаност с Blackwell, въпреки че, както проучихме по-рано, това представлява някои уникални предизвикателства поради факта, че PCIe 5.0 не е достатъчно бърз, а PCIe 6.0 все още е малко далеч.

Кога можем да видим тези Blackwell карти все още е във въздуха, но ако историята е нещо, което трябва да се вземе предвид, може да не се наложи да чакаме толкова дълго. Nvidia има дълга история на предварително обявяване на ускорители месеци (и наистина понякога години), преди те действително да бъдат налични за закупуване.

Nvidia дразнеше своя Grace-Hopper Superchip в началото на 2022 г., но както разбираме, тези части едва сега си проправят път в ръцете на клиентите. Така че можем да имаме повече подробности за базираните на Blackwell части още в GTC.

Intel посреща новата година с изцяло нов собствен ускорител

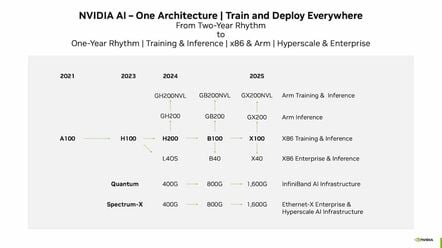

Придържайки се към темата за ускорителите, Intel е планирано да разкрие своето трето поколение Gaudi AI чипове някъде през 2024 г.

Участието е важно, тъй като с отмяната на моста Риалто, наследника на Понте Векио, Gaudi3 на Habana Lab представлява най-доброто, което Intel може да предложи на арената за обучение и изводи на AI – поне докато Falcon Shores пристигне през 2025 г.

Докато Nvidia и AMD имат навика да дразнят и рекламират своите продуктови издания в продължение на месеци, Intel беше изключително мълчалив относно тази част. По-голямата част от това, което видяхме досега, идва от този презентационен слайд, който показва най-малко от събитието за иновации през септември:

Слайдът твърди, че Gaudi3, 5nm чип, ще има 4 пъти по-висока производителност на Brain Float 16 (BF16) от 7nm версия 2, плюс два пъти по-голяма честотна лента на мрежата и 1,5 пъти по-висока честотна лента на HBM.

Обикновено тези цифри ще ни дадат отправна точка за екстраполиране на относителни данни за ефективност. За съжаление, за да направи това, Intel ще трябва да ни каже какво всъщност е представянето на BF16 на Gaudi2. Попитахме и те не искат да говорят за това, въпреки че твърдят, че 4x подобрение в Gaudi3. Вместо това Intel иска да се съсредоточи върху производителността в реалния свят, а не върху сравненията с бенчмаркове.

Това е откровено объркващо маркетингово решение, тъй като твърдението по същество е безсмислено без референтна рамка. Освен това, както изглежда, този път x86 гигантът използва осем HBM стека вместо шест.

В допълнение към Gaudi3, казаха ни, че ще има версия на Gaudi2, намалена – отново – за китайския пазар (за да остане от дясната страна на експортните ограничения на САЩ за нацията) и Intel твърди, че ще я достави преди Слуховете за чипове H20 на Nvidia стигнаха до континента.

Intel се присъединява към екипа на облачните процесори със Sierra Forest

Междувременно на фронта на процесора, Intel има двойна функция, планирана за 2024 г., която ще използва своята дълго отлагана технология за процеси Intel 3. За да бъде ясно, Intel не е направила внезапен скок към 3nm. Той работи върху този възел, който наричаше 7nm, от години. В крайна сметка той беше преименуван на Intel 4 и Intel 3, за да се доближи по маркетингова линия до плътността на транзисторите на конкурентните възли.

Ще получим първия от тези базирани на Intel-3 процесори Xeon през първата половина на 2024 г. С кодовото име Sierra Forest, чипът може да бъде оборудван с чифт 144-ядрени матрици за общо 288 CPU ядра на сокет. Естествено, това не са същия клас ядра, които сме виждали в минали Xeon. Те са еволюция на архитектурата на ядрото за ефективност на Intel, която започна да се появява в процесорите за компютри и преносими компютри през 2021 г. с пускането на пазара на Alder Lake .

Но докато тези чипове обикновено са придружени от набор от ядра за производителност, Sierra Forest е изцяло с електронни ядра и е проектиран да се конкурира с Ampere, AMD и множество персонализирани процесори Arm, които се внедряват от облачни доставчици като AWS и Microsoft.

Електронните ядра, използвани в Sierra Forest Xeons на Intel, ще разполагат с рационализирана основна архитектура, оптимизирана за ефективност и производителност

Твърденото предимство на Intel е, че може да опакова повече ядра в един сокет или шаси от всеки друг, като същевременно поддържа съвместимост с повечето x86 бинарни файлове. Казваме мнозинството, защото е-ядрата нямат същия набор от функции като миналите Xeon.

Две от най-големите разлики е пълната липса на поддръжка на AVX512 и Advanced Matrix Extension (AMX). Аргументът тук е, че много от работните натоварвания, които виждаме широко разгърнати в облака – неща като Nginx – не се възползват непременно от тези функции, така че вместо да отделят голямо количество пространство за големи векторни и матрични изчисления, това пространство вместо това може да се използва за пакетиране на повече ядра върху всяка матрица.

Не всяка къща за чипове обаче е съгласна с този подход. AMD възприе много различен подход със своя Bergamo Epycs, пуснат през пролетта на 2023 г. Тези сървърни процесори използваха компактна версия на ядрото Zen 4 на AMD, наречено Zen 4c, което размени тактовите честоти за по-малък отпечатък. Това позволи на AMD да опакова 128 ядра в осем изчислителни матрици на процесорен пакет, без да жертва функционалността.

И двата подхода имат достойнства. В зависимост от хипервайзора, липсата на определени функции на процесора може да направи мигрирането на работни натоварвания от една кутия в друга проблематична. Intel се надява да преодолее това с AVX10, в който се потопихме дълбоко през лятото. Накратко, той е проектиран да поддържа много от по-привлекателните функции, като поддръжка на FP16 и BF16, от AVX512 към AVX2. Резултатът е, че е по-малко вероятно да се натъкнете на този вид проблеми с миграцията, освен ако наистина не се нуждаете от 512-битови векторни регистри.

Intel слиза на земята с Granite Rapids

Преминавайки към по-малко известни територии, има Granite Rapids Xeons на Intel, които трябва да се появят по-късно през 2024 г. Докато Sierra Forest дава приоритет на много малки ядра, Granite Rapids е по-традиционен сървърен процесор Xeon, изграден около ядрата за производителност на x86 гиганта.

Все още не знаем колко ядра ще има или колко бързи ще бъдат частите от най-горния бин, но ни казаха, че ще бъде повече от Emerald Rapids. Знаем, че чипът ще разполага с по-модулна чиплетна архитектура от Sapphire или Emerald Rapids, с до пет матрици – три изчислителни и две I/O – на пакет.

В зависимост от SKU, чипът ще включва повече или по-малко изчислителни матрици, позволявайки на Intel да се възползва от модулността, на която AMD се радва от години. Преди това Xeons от 2023 г. имаха или една голяма матрица със среден брой ядра (MCC), или две големи (Emerald) или четири по-малки (Sapphire) изчислителни матрици на така наречените матрици за „изключителен брой ядра (XCC).

Процесорите Xeon Scalable от 6-то поколение на Intel – Sierra Forest и Granite Rapids – ще се предлагат във версии с e-core и p-core и ще поддържат до 12 канала DDR5 или поне така ни е обещано

Xeons от следващо поколение на Intel разделят входно/изходната функционалност в двойка матрици, които свързват изчислението. Тези входно/изходни матрици са важни, тъй като помагат да се намали разликата с AMD, която не само има предимство в броя на ядрата през последните пет години, но обикновено предлага повече, по-бързи PCIe ленти и канали за памет.

Както научихме по време на конференцията Hot Chips през 2023 г., Granite Rapids ще разполага с 12 канала за памет — същото като Epyc 4 на AMD — и ще поддържа 8800MT/s MCR DIMMS. MCR е доста страхотен, тъй като ще позволи на чипа да достави 845GB/s честотна лента на паметта към чипа. Това не е точно 1TB/s, на който са способни частите на Xeon Max от 4-то поколение на Intel с техния вграден HBM, но MCR DIMMS ще се доближи и ще позволи значително по-висок капацитет.

Семейството чипове също ще поддържа до 136 PCIe / CXL ленти, но само при скорости на PCIe 5.0. PCIe 6.0 може да се появи през 2024 г., но не навреме за „следващото поколение“ Xeons на Intel.

Zen 5 на AMD пристига

След това, разбира се, AMD трябва да пусне Turin, своето пето поколение сървърни процесори Epyc, задвижвани от нови Zen 5 ядра. На този етап не можем да кажем много за тази част, освен че идва някъде през 2024 г.

Имайки предвид времето, можем да направим няколко предположения. Бихме се обзаложили, че чипът ще използва или 4nm, или 3nm технология на TSMC в своите изчислителни плочки, но е трудно да се каже дали I/O матрицата все още ще получи свиване на процеса.

Най-новата пътна карта на сървъра Epyc на AMD

Отвъд това можем само да посочим скорошни течове , споделени чрез Xitter, които предполагат, че AMD може отново да увеличи броя на ядрата в своята гама. Ако течовете са верни, може да гледаме процесори Epyc с до 128 ядра Zen 5 или 192 ядра Zen 5c.

Самите матрици с ядрени комплекси (CCD) изглежда не са се променили много от Genoa и Bergamo с осем или 16 ядра съответно на чиплет. Вместо това се съобщава, че AMD ще използва 16 изчислителни матрици за общото си предназначение и 12 изчислителни матрици, ориентирани към облака, за да постигне заявения брой ядра. Като казахме това, ще трябва да изчакаме и да видим дали течовете са точни.

Продуктовата линия Eypc на AMD стана по-сложна през последните години, като сега обхваща приложения с общо предназначение, високопроизводителни изчисления, облачни и крайни приложения. AMD традиционно пусна тези чипове в продължение на около година. Epyc 4 стартира през ноември 2022 г., Bergamo и Genoa-X пристигнаха през юни 2023 г., а неговите части, фокусирани върху Сиена, се появиха едва през септември.

Очакват изненади

За да бъдем напълно ясни, това в никакъв случай не е изчерпателен списък на процесорите за центрове за данни, идващи през 2024 г. Напълно очакваме да има повече от няколко изненади през следващите дванадесет месеца, особено когато влакът на AI набира скорост и облачните доставчици продължават да прегърнете персонализирания силикон.

Microsoft наскоро се впусна в персонализираното AI и CPU пространство, докато Google вече има няколко поколения тензорни процесори и се говори, че работи върху собствен CPU.

Ще наблюдаваме и усилията на Arm да прокара своята основна архитектура Neoverse и IP стекове на Compute Subsystems (CSS). Последното е най-близкото, което сме виждали Arm да стига до проектирането на цял процесор в съвременните времена.

Има и множество полупроводникови стартиращи фирми, като Ampere, Graphcore, Cerebras, SambaNova, Groq и други, които искат да намерят ниша в новия световен ред на AI. Едва ли ще се изненадаме да видим нов силиций, продукти и системи от някой от тези доставчици през 2024 г. ®